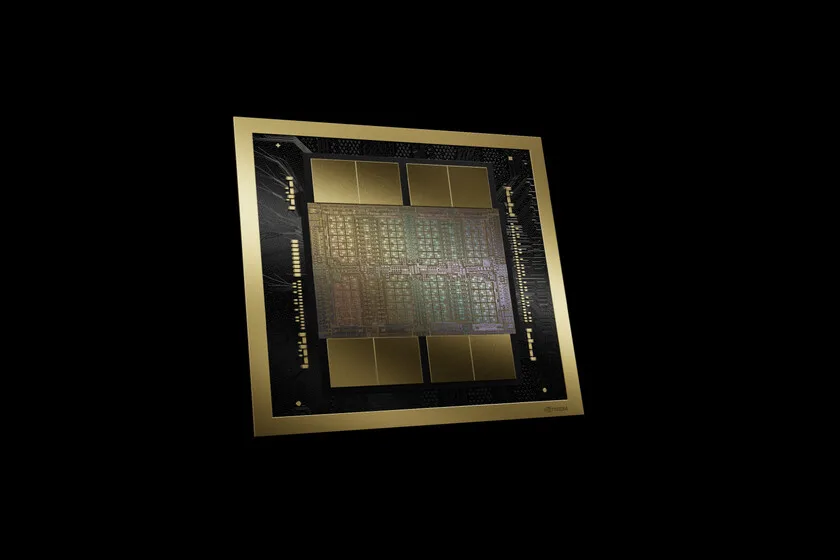

En el competitivo ámbito de la inteligencia artificial (IA), NVIDIA sigue marcando la pauta al presentar su innovadora arquitectura Blackwell, con los chips B200 y GB200 como protagonistas. La evolución de NVIDIA es notoria, sucesivamente lanzando chips cada vez más potentes; desde los A100 en 2020 con 54.000 millones de transistores, pasando por los H100 con 80.000 millones en 2022, hasta llegar al impresionante salto a los 208.000 millones de transistores con la nueva generación.

El chip B200 destaca por su rendimiento de hasta 18 petaFLOPS en operaciones FP4 en una configuración estándar, el cual puede incrementarse a 20 petaFLOPS con refrigeración líquida. Con un ancho de banda de memoria de 8 TB/s y capacidad para 192 GB de VRAM, este chip promete ser una revolución en eficiencia energética, ofreciendo hasta 25 veces menos consumo que su predecesor, el H100.

Por otra parte, el chip GB200 eleva aún más la apuesta al integrar una CPU Grace de 72 núcleos con dos GPU B200, logrando un rendimiento teórico máximo de 40 petaFLOPS en operaciones FP4 y 384 GB de memoria HBM3e. Este «superchip» facilita la interconexión a alta velocidad gracias al sistema NVLink-C2C, potenciando la ejecución de tareas de IA.

Estos avances son cruciales en la era de la IA, donde el entrenamiento de modelos de lenguaje avanzados, como GPT-4 de OpenAI o Claude 3 de Anthropic, requiere de capacidades de hardware cada vez más potentes y eficientes. NVIDIA también eleva las capacidades de los centros de datos con configuraciones DGX que pueden manejar modelos de hasta 27 billones de parámetros, ofreciendo más de 1 exaFLOP de rendimiento, superando ampliamente las capacidades del primer sistema DGX entregado a OpenAI.

A medida que NVIDIA continua innovando, su compromiso con el avance de la inteligencia artificial se solidifica, manteniéndose a la vanguardia frente a competidores emergentes y asegurando su posición de liderazgo en el mercado.